【scikit-learn】LogisticRegressionでロジスティック回帰をする方法

Python の機械学習ライブラリである scikit-learn の LogisticRegression を使ってロジスティック回帰によるデータ分類を行う方法を解説します。

目次

ロジスティック回帰

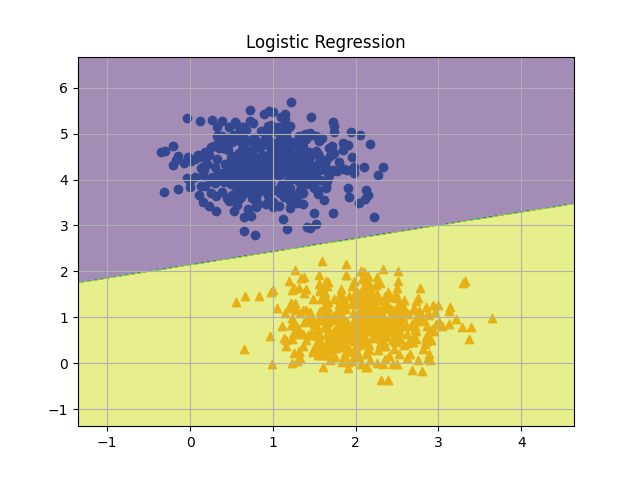

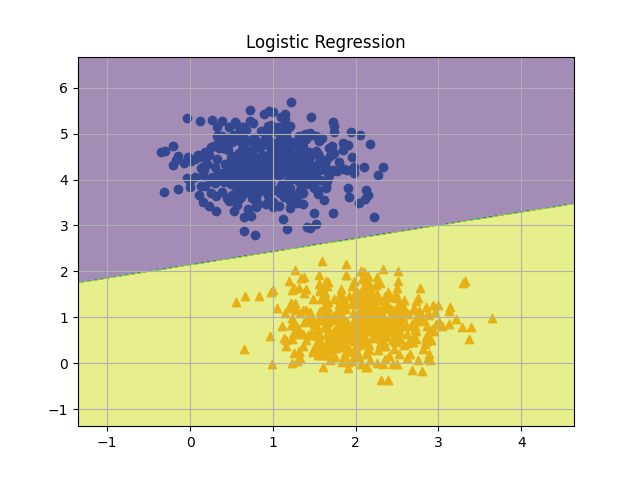

ロジスティック回帰とは、線形分離可能なデータに対して境界線を学習により見つけてデータ分類を行う手法の事です。名前に「回帰」とついていますが「分類」のための手法ですので間違えないようにしましょう。

特徴としては、境界線が直線になることが挙げられます。そのため、2 つのクラスに分類する二項分類等によく用いられます。例えば、品質データとして取得された特徴群から製品の「合格品」「不良品」を分類するというような場合です。

ロジスティック回帰は、Python の機械学習ライブラリの scikit-learn に LogisticRegression として実装されています。この記事では、LogisticRegression でデータを分類する方法を紹介します。

scikit-learn の LogisticRegression でロジスティック回帰をする方法

以降では scikit-learn を使用します。インストールされていない場合は pip でインストールしておいてください。

pip install scikit-learn

ロジスティック回帰の使い方

(sklearn.linear_model.LogisticRegression)

実装例

scikit-learn の make_blobs で分類用のデータを用意し、LogisticRegression を使ってロジスティック回帰による分類をする方法について紹介します。

import matplotlib.pyplot as plt

import numpy as np

from sklearn.datasets import make_blobs

from sklearn.linear_model import LogisticRegression

def main():

"""メイン関数"""

np.random.seed(0)

# ===== データの生成

data, label = make_blobs(n_samples=1000, centers=2, cluster_std=0.5)

plt.scatter(data[label == 0, 0], data[label == 0, 1], marker="o")

plt.scatter(data[label == 1, 0], data[label == 1, 1], marker="^")

# ===== ロジスティック回帰を用いた学習

model = LogisticRegression()

model.fit(data, label)

# ===== 分類結果の可視化

xmin, xmax = data[:, 0].min() - 1, data[:, 0].max() + 1

ymin, ymax = data[:, 1].min() - 1, data[:, 1].max() + 1

xx, yy = np.meshgrid(np.arange(xmin, xmax, 0.01), np.arange(ymin, ymax, 0.01))

zz = model.predict(np.array([xx.ravel(), yy.ravel()]).T).reshape(xx.shape)

plt.contourf(xx, yy, zz, alpha=0.5)

plt.title("Logistic Regression")

plt.grid(True)

plt.show()

if __name__ == "__main__":

main()

実装内容の解説

上記で紹介した実装例の各部分ごとに内容を紹介していきます。

必要モジュールのインポート

import matplotlib.pyplot as plt import numpy as np from sklearn.datasets import make_blobs from sklearn.linear_model import LogisticRegression

まずは、必要なモジュールをインポートします。今回は scikit-learn の LogisticRegression を使用するので、sklearn.linear_model からインポートしておきます。また、データ生成用に make_blobs をインポートし、numpy と matplotlib はデータ操作や可視化用でインポートします。

データセットの準備

np.random.seed(0)

# ===== データの生成

data, label = make_blobs(n_samples=1000, centers=2, cluster_std=0.5)

plt.scatter(data[label == 0, 0], data[label == 0, 1], marker="o")

plt.scatter(data[label == 1, 0], data[label == 1, 1], marker="^")データは make_blobs を使って生成します。指定しているパラメータとしては以下のような項目です。今回は 2 クラスのデータを作成して分類器を学習させます。

n_samples:データ点数centers:データのクラス数cluster_std:各クラスのデータの標準偏差

乱数シードは np.random.seed で設定していますが、make_blobsのrandom_state 引数で指定することも可能です。

モデルの学習

# ===== ロジスティック回帰を用いた学習

model = LogisticRegression()

model.fit(data, label)ロジスティック回帰のモデルを作成しているのが上記の部分です。生成データと正解ラベルを渡すだけでデータに対してロジスティック回帰のモデルが作成できます。

結果の可視化

# ===== 分類結果の可視化

xmin, xmax = data[:, 0].min() - 1, data[:, 0].max() + 1

ymin, ymax = data[:, 1].min() - 1, data[:, 1].max() + 1

xx, yy = np.meshgrid(np.arange(xmin, xmax, 0.01), np.arange(ymin, ymax, 0.01))

zz = model.predict(np.array([xx.ravel(), yy.ravel()]).T).reshape(xx.shape)

plt.contourf(xx, yy, zz, alpha=0.5)

plt.title("Logistic Regression")

plt.grid(True)

plt.show()学習で使ったデータではないデータを作成し predict メソッドにより各点の分類結果を確認しています。具体的には、学習に使ったデータ範囲の ±1 のデータ範囲でメッシュグリッドを作成して、各点における分類結果を計算します。結果を contourf で可視化することで、どのデータ範囲がどちらに分類されるかを確認しています。

結果を再掲しますが、各色で表現された範囲が各クラスに分類されることになります。冒頭でロジスティック回帰の特徴として説明した通り、境界面は直線となっていることがよく分かります。

まとめ

Python の機械学習ライブラリである scikit-learn の LogisticRegression を使ってロジスティック回帰によるデータ分類を行う方法を解説しました。

ロジスティック回帰は、比較的シンプルでありながら色々な場面で活用ができます。scikit-learn を用いると上記のように非常に簡単に実装して確認ができますので、是非使ってみてください。

上記で紹介しているソースコードについては GitHub にて公開しています。参考にしていただければと思います。

の使用方法.jpg)